Utilisation de la mémoire GDDR comme RAMFS : Une solution ultra-rapide pour le stockage temporaire

Introduction

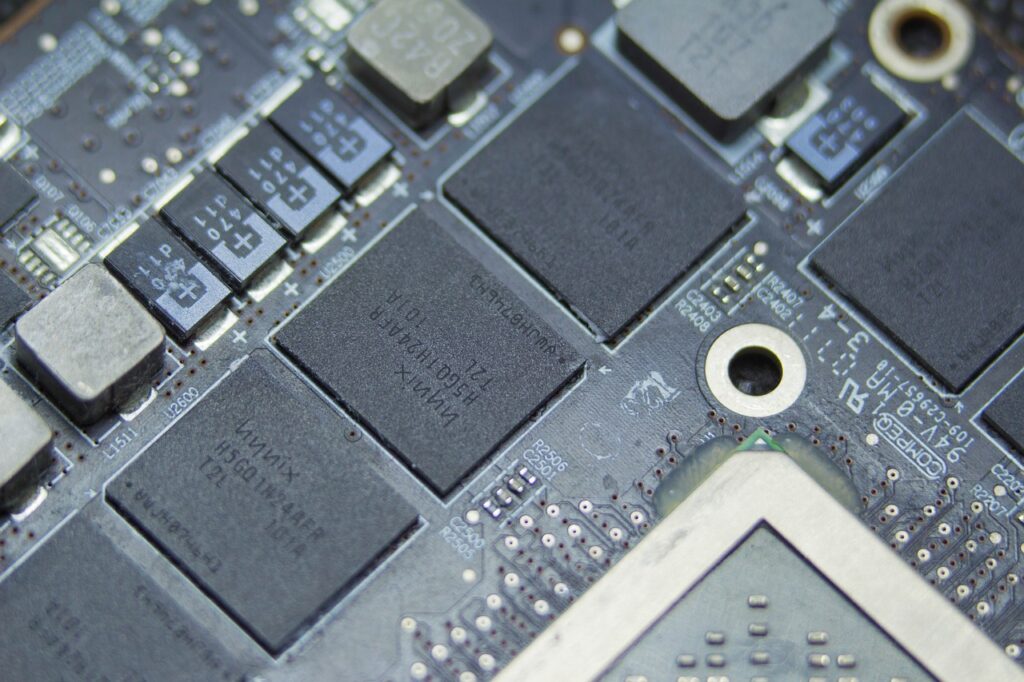

Les puces GDDR sont des puces de mémoire très rapides en liaison avec le contrôleur de processeur graphique GPU qui lui même à capacité à traiter très rapidement le transit de données sur ces mémoires volatiles via le bus PCI Express (Northbridge X86).

| Version/Technologie | Bande passante maximale (totale) | Version/Technologie |

|---|---|---|

| GDDR5 | Jusqu’à 256 Go/s (interface 256 bits) | Standard pour les GPUs jusqu’à 2018 NRZ signaling Tension : 1.5 V |

| GDDR6 | Jusqu’à 512 Go/s (interface 256 bits) | Double canal par puce (x16 ou x32) Tension réduite à 1.35 V Massivement utilisé sur les GPU récents |

| SSD PCIe 4.0 | Jusqu’à 8 Go/s (théorique) | Débit réel pratique : jusqu’à 7 Go/s Standard sur les SSD haut de gamme actuels |

| SSD PCIe 5.0 | Jusqu’à 16 Go/s (théorique) | Débit réel pratique : jusqu’à 12 Go/s Nouvelle génération de SSD ultra-rapides |

L’idée d’utiliser la mémoire GDDR (Graphics Double Data Rate), principalement dédiée aux calculs graphiques et au traitement intensif sur GPU, en tant que système de fichiers en mémoire (RAMFS) est un concept innovant. Plutôt que d’utiliser de la mémoire volatile classique (comme la RAM), ce concept propose d’exploiter la bande passante extrêmement élevée et la faible latence des puces GDDR pour créer un espace de stockage temporaire ultra-rapide, avec des avantages potentiels dans des applications nécessitant un accès rapide aux données.

Pourquoi utiliser la GDDR comme RAMFS ?

- Vitesse de lecture et écriture exceptionnelles :

- Les puces GDDR6 peuvent atteindre une bande passante allant jusqu’à 512 Go/s, bien supérieure à celle de la RAM traditionnelle ou des SSD NVMe. Cette bande passante pourrait permettre de gérer des fichiers temporaires à une vitesse bien plus rapide que les solutions de stockage classiques.

- RAMFS est un système de fichiers qui stocke toutes les données directement en mémoire. En utilisant la GDDR, un tel système pourrait offrir des vitesses de lecture/écriture proches de celles des GPU, idéales pour des opérations nécessitant des accès fréquents et rapides aux données.

- Cache ultra-rapide pour les processus de calcul intensif :

- Dans des environnements comme les calculs scientifiques, l’apprentissage automatique, ou le rendu graphique, une grande quantité de données temporaires est traitée constamment. Utiliser la GDDR comme RAMFS permettrait de stocker ces données en mémoire à très haut débit, améliorant considérablement les performances en éliminant les goulots d’étranglement liés aux disques ou à la RAM classique.

- Optimisation de l’usage de la mémoire volatile :

- Contrairement à la RAM traditionnelle, qui est relativement plus lente, la GDDR offre une bande passante et une latence bien plus basses, ce qui la rend idéale pour des applications où la vitesse de traitement et l’accès rapide aux fichiers temporaires sont essentiels.

- Optimisation de l’inactivité (taux d’occupation inutile) de la mémoire GDDR :

- Bien que les puces GDDR offrent une bande passante exceptionnelle, elles ne sont souvent pas utilisées à 100% de leur capacité dans de nombreuses applications. Les GPU sont conçus pour des charges de travail spécifiques, principalement liées aux graphiques et aux calculs parallèles massifs, où la mémoire est utilisée de manière séquencée et optimisée. Cependant, dans des applications non graphiques ou moins intensives en données, la bande passante de la GDDR peut rester sous-exploitée. De plus, les goulots d’étranglement dans la communication entre le CPU et la GDDR, via le bus PCIe, limitent l’exploitation complète de cette mémoire. Cela signifie qu’une grande partie de la capacité de la GDDR peut être inutilisée dans certains contextes, créant des opportunités pour des solutions qui pourraient tirer parti de cette bande passante excédentaire, comme l’utilisation de la GDDR en tant que système de fichiers temporaire ou pour des tâches intensives en mémoire.

Défis techniques à surmonter

- Compatibilité matérielle et logique :

- La GDDR n’est pas conçue pour être utilisée comme un espace de stockage classique. Les systèmes de fichiers comme RAMFS (qui stocke directement en mémoire vive) sont optimisés pour des mémoires comme la RAM, et non pour la GDDR. Pour que ce concept fonctionne, il faudrait développer des mécanismes logiciels permettant de mapper les fichiers temporairement sur la GDDR, tout en optimisant les accès et la gestion de la mémoire.

- Volatilité de la GDDR :

- La GDDR est une mémoire volatile, ce qui signifie que toutes les données stockées seraient perdues lors d’un redémarrage du système ou d’une coupure d’alimentation. Cela limite son usage aux cas où la persistance des données n’est pas nécessaire, comme pour des fichiers temporaires ou des caches utilisés pendant les calculs, mais pas pour des données critiques ou permanentes directement.

- Usure des puces GDDR :

- Bien que la GDDR soit conçue pour des charges de travail intensives, l’utilisation comme espace de stockage pour des opérations de lecture/écriture fréquentes pourrait entraîner une usure prématurée des puces. Ce point est crucial, car les cycles de lecture et d’écriture pour un usage RAMFS seraient bien plus élevés que ceux observés dans les applications graphiques classiques.

- Limitation de la communication via PCIe :

- Les GPU (et donc la GDDR) communiquent avec le CPU via le bus PCIe. Bien que PCIe 5.0 offre un débit théorique allant jusqu’à 16 Go/s, cela reste bien inférieur à la bande passante native de la GDDR. Ce goulot d’étranglement peut limiter la performance globale du système RAMFS basé sur GDDR, car l’accès direct à la GDDR par le CPU serait limité.

Applications possibles avec GDDR comme RAMFS

- Cache pour les applications de calcul intensif :

- Dans des domaines tels que l’intelligence artificielle (IA), l’apprentissage automatique ou le rendu 3D, où de gros volumes de données sont manipulés en temps réel, la GDDR en RAMFS pourrait servir de cache ultra-rapide pour les fichiers temporaires, accélérant ainsi les processus de calcul.

- Accélération des systèmes de bases de données :

- Les bases de données en mémoire (comme Redis) bénéficieraient d’un tel système, où des données volumineuses peuvent être traitées à une vitesse proche de celle du processeur, offrant une réduction significative des latences et une gestion de données ultrarapide.

- Amélioration des performances des simulations complexes :

- Dans des domaines tels que la simulation physique, la modélisation ou la visualisation scientifique, la GDDR comme RAMFS pourrait être utilisée pour stocker les données intermédiaires et les résultats d’analyse temporaire avec des performances accrues.

Approfondissement

L’utilisation de la GDDR comme un RAMFS dans un programme (en language C par exemple) est techniquement réalisable en utilisant des bibliothèques comme CUDA et OpenCL. Ces outils permettent d’accéder directement à la mémoire GDDR, de gérer des données temporaires à très haut débit, et de développer des systèmes de fichiers en mémoire.

Accès direct à la mémoire GDDR avec CUDA et OpenCL

Les bibliothèques CUDA (pour les GPU NVIDIA) et OpenCL (pour les GPU de différents fabricants) permettent une gestion fine de la mémoire GDDR. Elles permettent d’allouer de la mémoire directement sur le GPU, d’y stocker des données et de les transférer entre le CPU et le GPU.

- CUDA : Fournit des fonctions comme

cudaMalloc()pour allouer de la mémoire sur la GDDR etcudaMemcpy()pour transférer des données entre le CPU et la GDDR. - OpenCL : Offre des fonctionnalités similaires à celles de CUDA, mais avec la possibilité de travailler sur une variété de GPU, y compris ceux d’AMD et d’Intel.

Ces deux technologies permettent de manipuler la GDDR de manière plus performante que la RAM traditionnelle, mais elles nécessitent un environnement de développement spécialisé et des compétences en programmation GPU.

Gestion de la mémoire pour un système de fichiers

Pour utiliser la GDDR en tant que RAMFS, il faut une stratégie de gestion de la mémoire. Le programme C devra interagir directement avec la mémoire GDDR en gérant des structures de données de type système de fichiers (comme les tables d’allocation ou les blocs de données).

- Allocation mémoire : Une fois la mémoire GDDR allouée via CUDA ou OpenCL, il est possible de simuler un système de fichiers en y insérant des données et en les organisant dans des structures adaptées.

- Transfert des données : Utiliser

cudaMemcpy()ou des fonctions OpenCL pour déplacer des fichiers ou des blocs de données entre la RAM et la GDDR en fonction des besoins d’accès rapide.

Défis et limitations

Même avec l’accès direct à la GDDR via CUDA ou OpenCL, plusieurs défis doivent être surmontés pour que cette solution soit viable :

- Volatilité : La GDDR étant volatile, toute coupure d’alimentation entraînera la perte des données. Cette solution convient donc uniquement pour des fichiers temporaires et des données volatiles.

- Latence PCIe : La communication entre le CPU et la GDDR se fait via PCIe, ce qui peut limiter la performance pour certaines applications nécessitant un accès direct et rapide aux fichiers.

- Usure de la GDDR : La GDDR est optimisée pour des accès séquentiels dans des scénarios graphiques. Des écritures fréquentes, aléatoires et sur de longues périodes pourraient entraîner une usure prématurée de la mémoire.

Cas d’utilisation typiques possibles

Malgré ces limitations, l’utilisation de la GDDR en tant que RAMFS est particulièrement adaptée à certains cas d’usage spécifiques :

- Applications de calcul haute performance : Par exemple, dans les simulations scientifiques ou l’apprentissage automatique, où la gestion des données temporaires (telles que les résultats intermédiaires de calcul) peut être effectuée à grande vitesse.

- Rendu graphique et vidéo : Pour des applications de rendu 3D ou de traitement vidéo en temps réel, où un accès rapide aux fichiers temporaires est crucial pour minimiser la latence.

Conclusion

Utiliser la GDDR comme un système de fichiers RAMFS en C, avec CUDA ou OpenCL, est techniquement possible, mais nécessite une gestion fine de la mémoire et des outils de programmation spécialisés. Cette approche permet de tirer parti des vitesses de transfert extrêmement rapides de la GDDR pour des applications nécessitant un stockage temporaire ultra-rapide. Cependant, elle reste limitée par des défis tels que la volatilité, l’usure et la latence de communication avec le CPU via PCIe. Pour des cas spécifiques de calcul intensif ou de rendu, cette solution pourrait apporter des améliorations significatives en termes de performance.